Advancing AI 2025: AMD lancia la sfida a NVIDIA, tutti gli annunci dell'evento su server e datacenter

L'evento Advancing AI 2025 di AMD ha fatto luce sulle strategie dell'azienda per il 2025 e il 2026 in campo server e datacenter, con l'annuncio delle nuove CPU EPYC e delle GPU Instinct

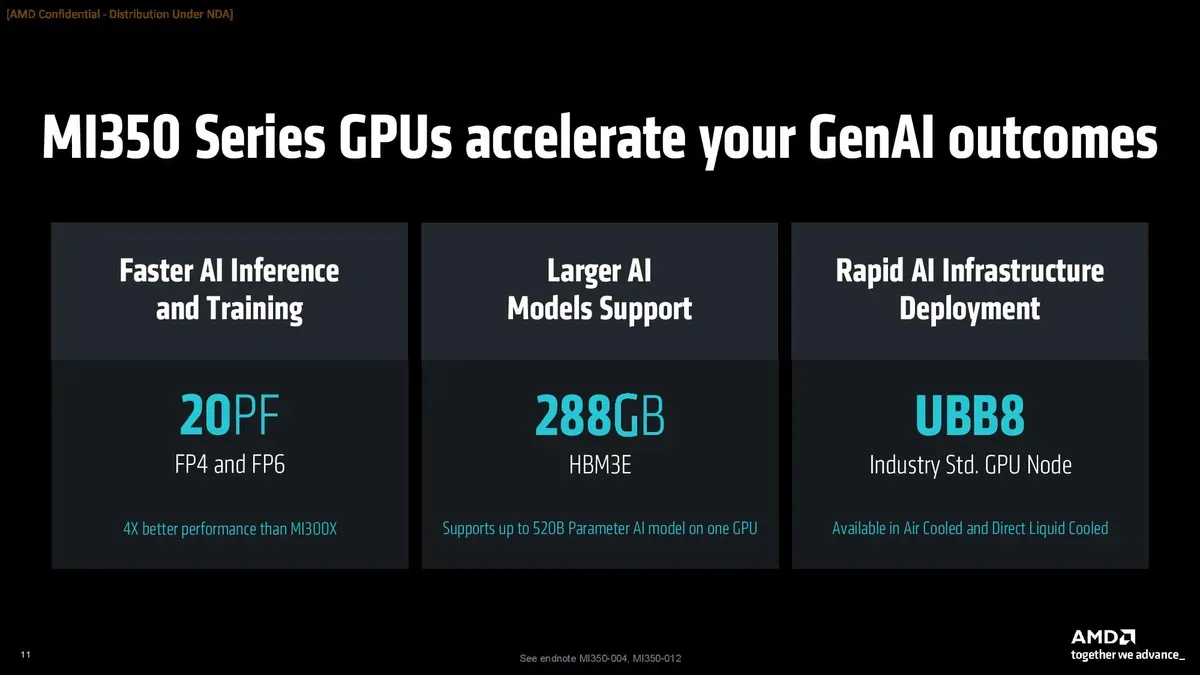

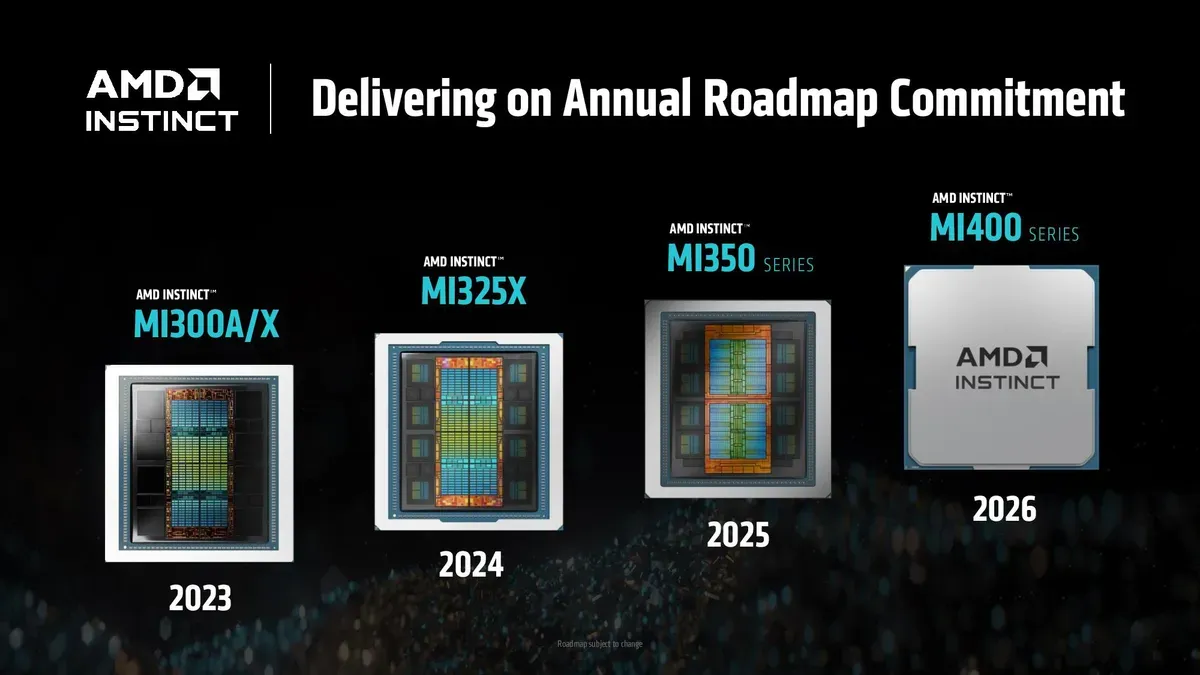

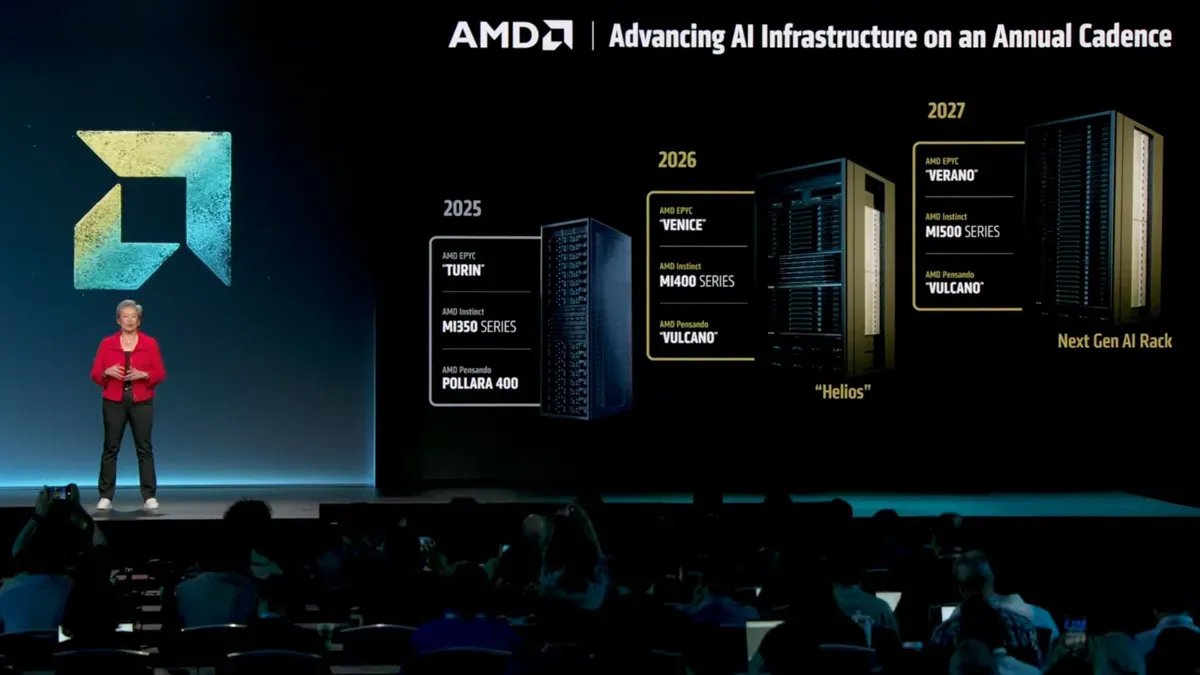

All’evento “Advancing AI 2025” AMD ha presentato le GPU Instinct MI350X e MI355X per carichi di lavoro basati sull'AI, con un incremento nelle prestazioni fino a volte rispetto ai modelli precedenti. L’azienda ha inoltre svelato il processore server EPYC Venice a 256 core, in arrivo nel 2026, e tracciato la roadmap fino al 2027 con l’EPYC Verano e la prossima generazione di GPU Instinct MI500X. Ecco tutti i dettagli degli annunci hardware per server e datacenter di AMD, e come potrebbero portare il Team Rosso a competere finalmente con NVIDIA anche nel campo dell'IA.

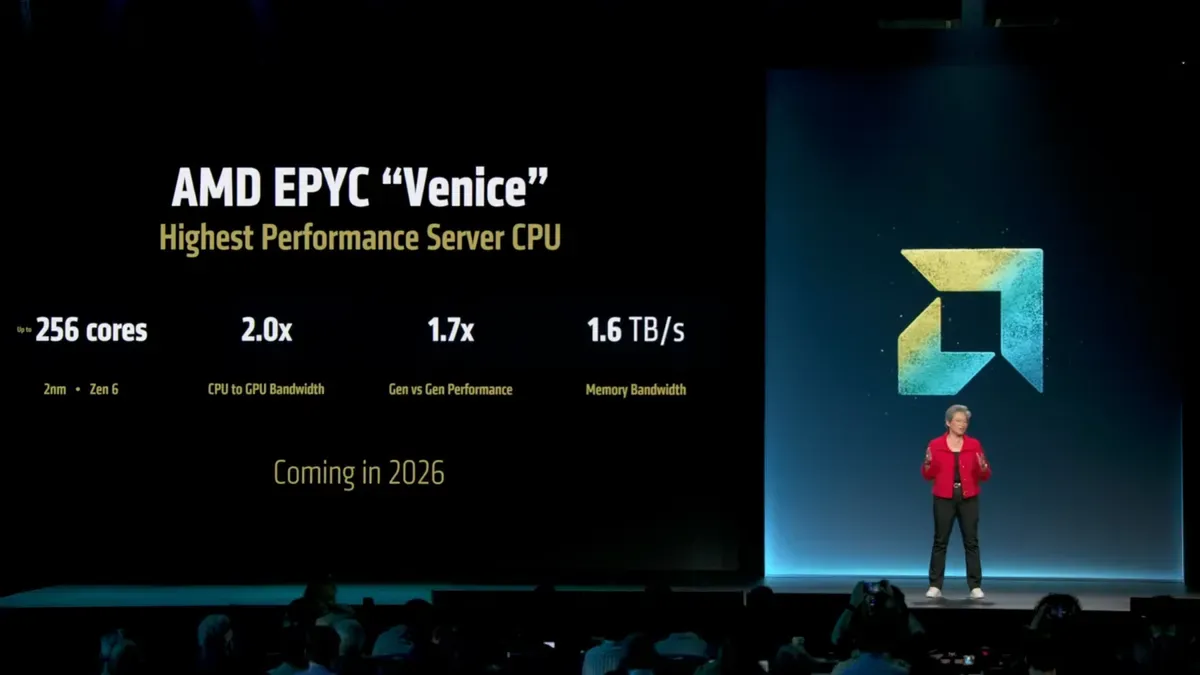

EPYC Venice 6a Gen

Fino a 256 Core Zen6

AMD ha fornito le prime informazioni tecniche sul processore server EPYC Venice di 6ª generazione, previsto per il 2026. Basato su Core Zen 6 fabbricati con tecnologia TSMC a 2 nm, Venice offrirà fino a 256 Core per socket (il 33% in più rispetto all’attuale serie “Turin”). Secondo AMD, questo salto di core consentirà fino al 70% di prestazioni in più rispetto agli EPYC 9005 (con architettura Zen 5) attualmente in commercio, estendendo - secondo la CEO Lisa Su - «la nostra leadership in ogni dimensione» del segmento dei data center.

Il nuovo processore EPYC amplia anche la connettività: per alimentare tutti quei core avrà 16 canali di memoria, raddoppiando la banda fino a circa 1,6 TB/s per socket (contro i 614 GB/s dei modelli current gen), probabilmente supportando moduli avanzati come MR-DIMM/MCR-DIMM. AMD prevede di raddoppiare anche la banda PCIe verso le GPU, adottando probabilmente l’interfaccia PCIe 6.0 con 128 linee (ciascuna fino a 128 GB/s bidirezionali). Per gestire questi componenti aggiuntivi, Venice utilizzerà il nuovo socket SP7, progettato per garantire oltre 700 W di potenza di picco. In sintesi, EPYC Venice si propone come CPU server top di gamma, con core e memoria amplificati, preparandosi a spingere la competizione anche sul fronte Intel.

AMD Instinct MI350X e MI355X

La nuova generazione di schede video per server e datacenter

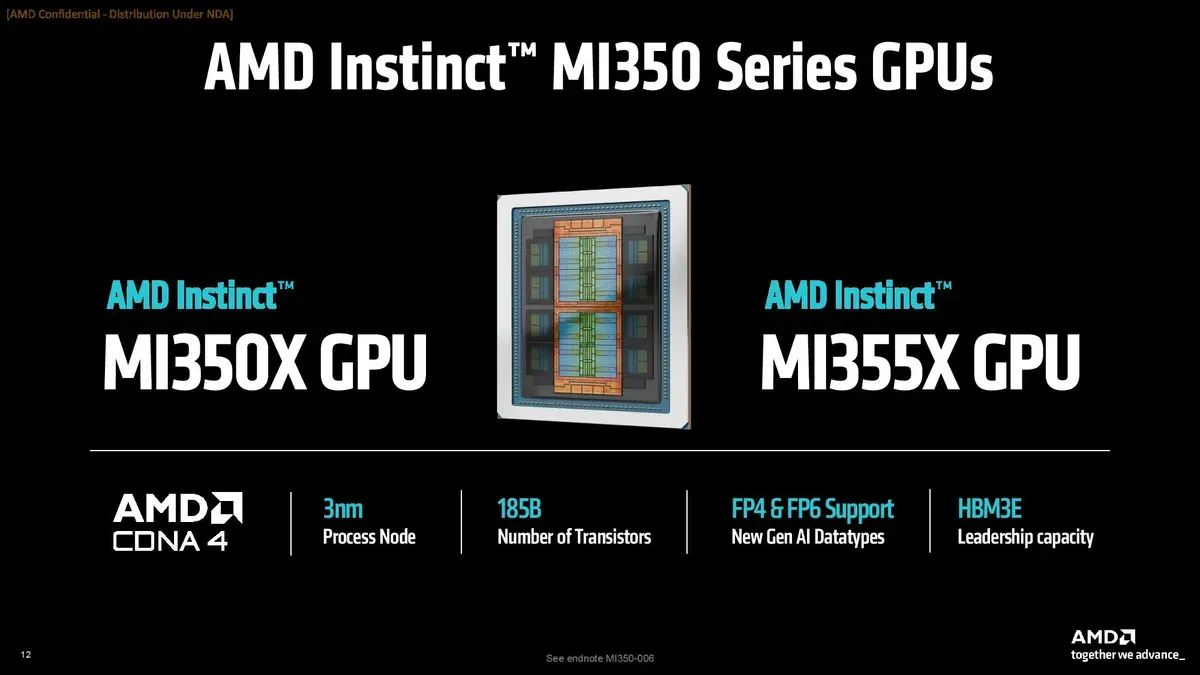

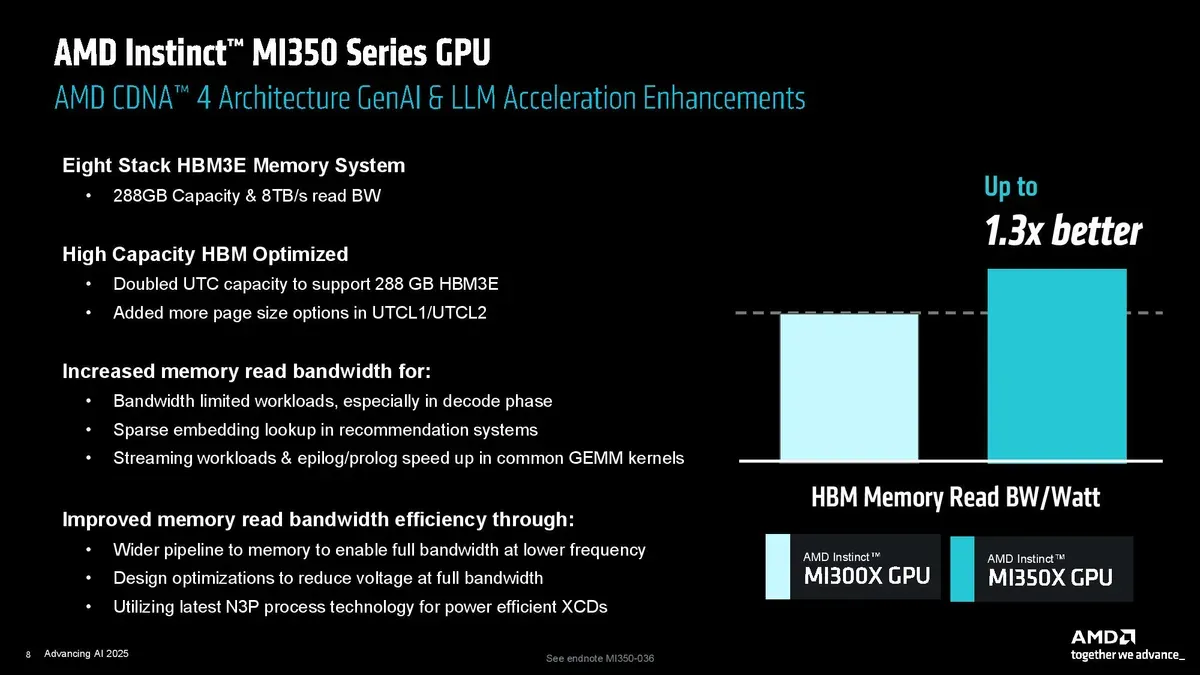

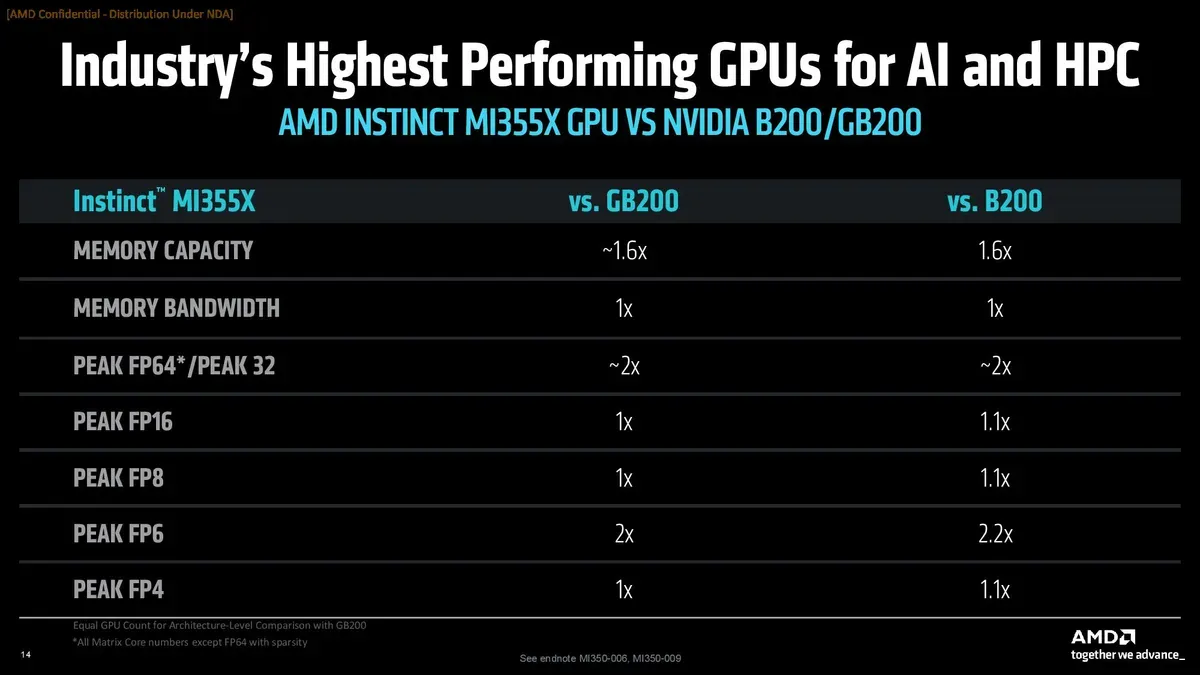

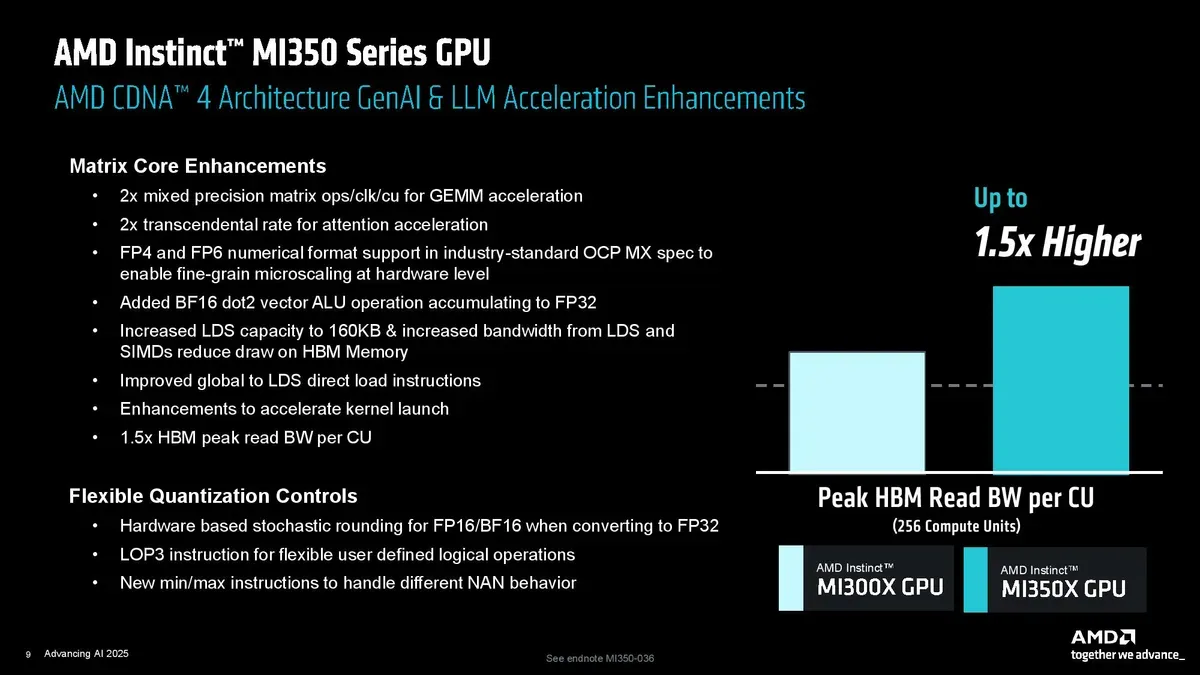

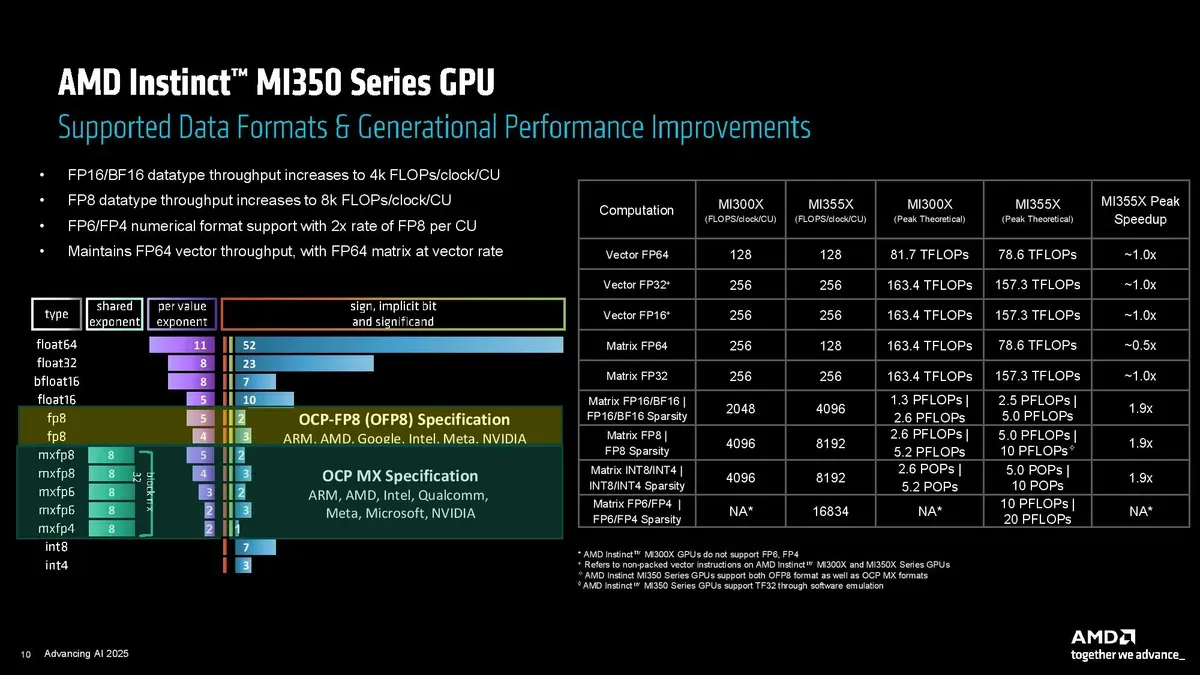

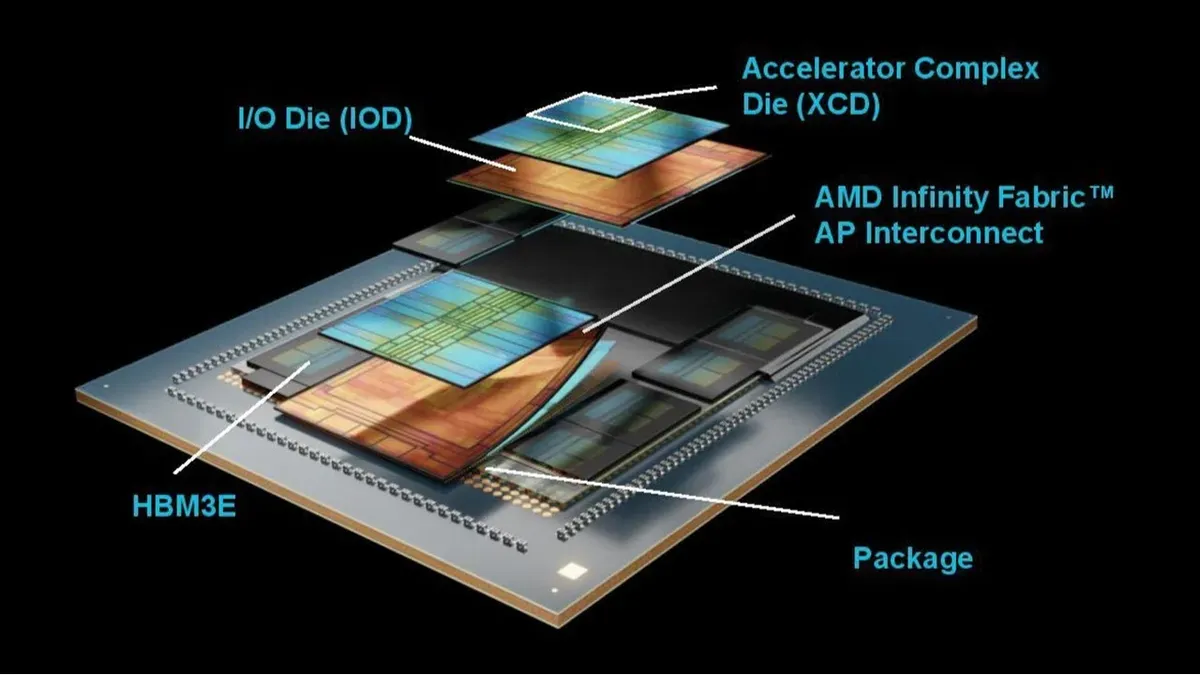

La GPU Instinct MI350X è stata annunciata come la nuova soluzione AI di fascia media di AMD (architettura CDNA 4). È la variante a raffreddamento ad aria di un design comune con la MI355X - che invece rappresenta l'offerta top di gamma del Team Rosso. Supporta fino a 288 GB di memoria HBM3E e 8 TB/s di banda passante memoria, oltre ai nuovi formati dati FP4 e FP6 ottimizzati per intelligenza artificiale. AMD dichiara che la MI350X offre circa tre volte le prestazioni AI del precedente MI300X. In termini assoluti, afferma un incremento fino a quattro volte nel computing legato all'Intelligenza Artificiale e fino a 35 volte nell'inferenza, grazie alla nuova architettura e al nodo di processo a 3 nm di TSMC. In confronto alle soluzioni dei competitor, AMD sostiene che la MI350X supera le GPU NVIDIA di pari classe nei benchmark di inferenza, migliorando i loro risultati di 1,3 volte. Questo rende la MI350X un prodotto competitivo nel mercato AI, soprattutto a fronte dell'impegno di AMD a mantenere un elevato rapporto prezzo-prestazioni.

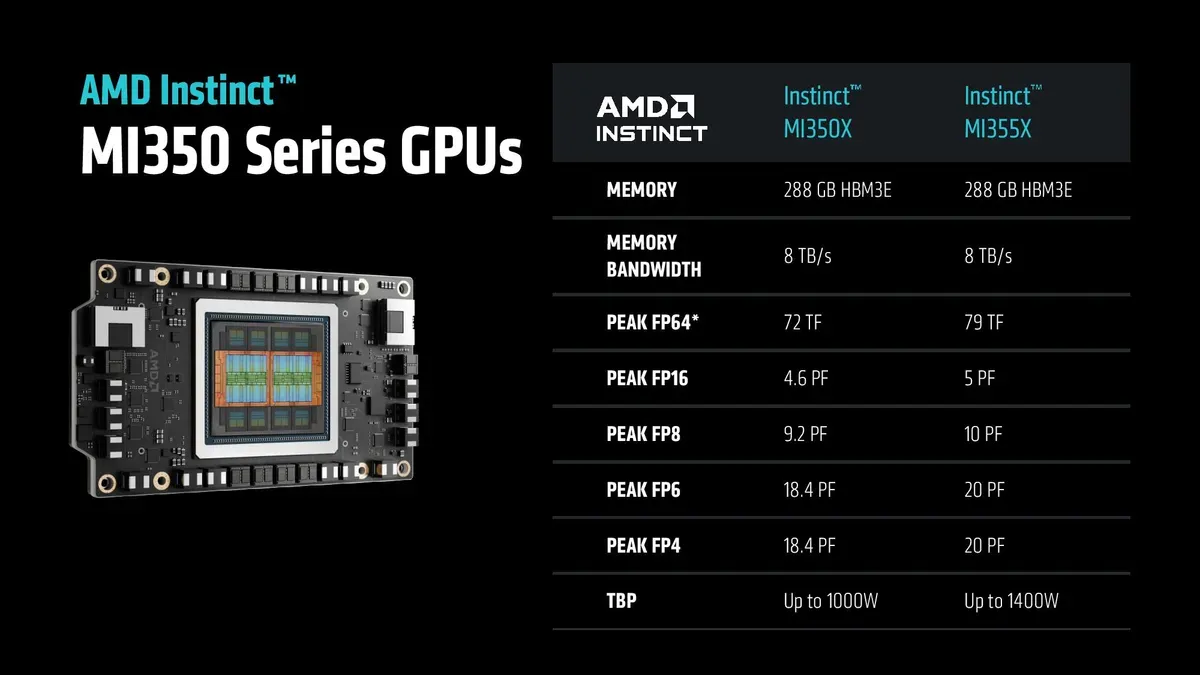

Le specifiche delle GPU Instinct MI350X e MI355X

La GPU Instinct MI355X è la versione di punta della serie MI350X, destinata a sistemi a raffreddamento liquido ad alte prestazioni. Condivide lo stesso chip della MI350X ma opera a frequenze più elevate. Supporta anche le istruzioni FP4 e FP6, offrendo prestazioni generazionali superiori (fino a 3–4 in più rispetto alla MI300X) ma con un consumo energetico maggiore. AMD non ha fornito dettagli esatti sui consumi, ma un’immagine comparativa indica un TDP intorno a 1400 W per la MI355X, contro circa 1000–1200 W della MI350X. L’idea è che la MI355X massimizzi le prestazioni AI possibili su una singola GPU, sacrificando efficienza energetica in favore di frequenze di picco e throughput superiore.

AMD Instinct MI400

Il futuro delle schede video per l'IA

La serie di schede video Instinct MI400 (nome in codice CDNA Next) rappresenta la generazione successiva di GPU AMD per l'IA, prevista per il 2026, ovviamente dopo gli acceleratori MI350X e MI355X. Il modello di punta, indicato informalmente MI400X, promette miglioramenti rilevanti: raddoppia le prestazioni rispetto al MI355X e incrementa del 50% la capacità di memoria, con oltre il doppio della larghezza di banda rispetto alla serie precedente. Dal punto di vista della potenza di calcolo, si parla di circa 20 PFLOPS FP4 (contro 10 del MI355X), mentre AMD dichiara che il MI400X sarà circa 10 volte più potente dell’MI300X lanciato nel 2023.

Nel confronto con NVIDIA, AMD afferma che il MI400X supererà le GPU Blackwell Ultra, pur riconoscendo che il futuro acceleratore Rubin R200 di NVIDIA offrirà circa 2.5× le prestazioni FP4 del MI400X. AMD punta comunque sul vantaggio competitivo di capacità e banda di memoria (ad esempio 51 TB HBM totali per rack vs 14 TB dell’attuale MI300) per mitigare il gap di throughput. In sintesi, MI400X è la GPU pensata per il rack AMD di nuova generazione Helios, progettata per fornire il massimo della densità computazionale AI disponibile in casa AMD nel 2026.

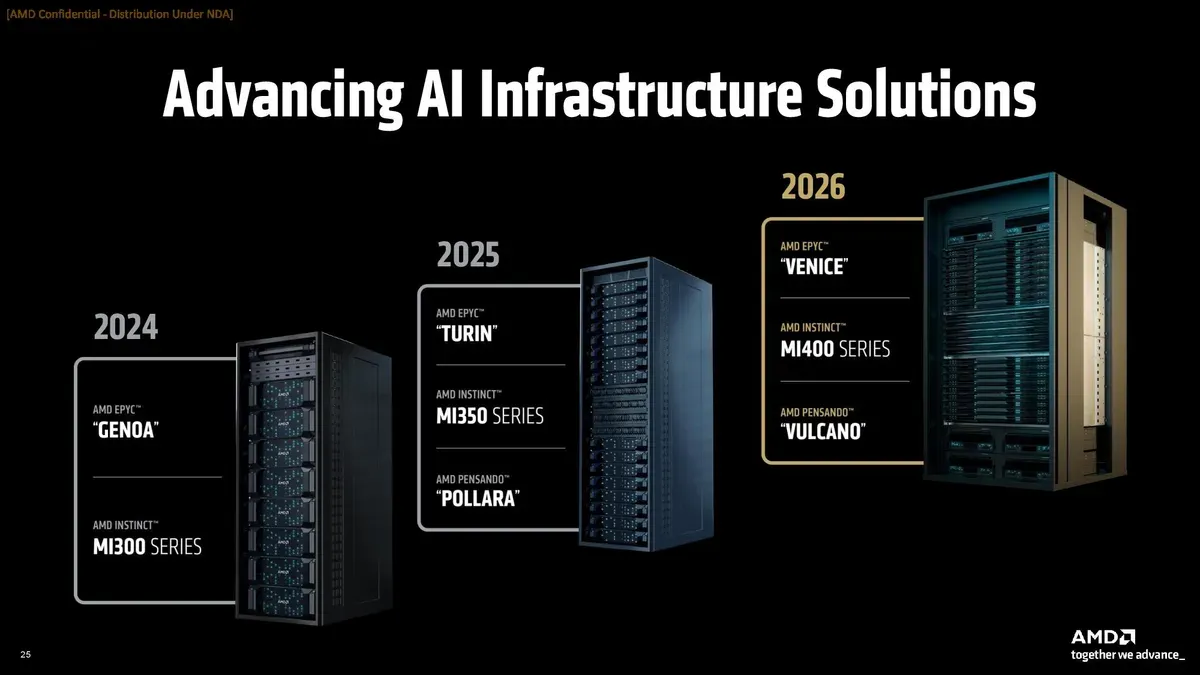

AMD Helios

Il nuovo sistema rack del Team Rosso

AMD ha svelato anche Helios, il suo primo sistema rack-scale AI progettato internamente. Atteso nel 2026, Helios integra i nuovi processori EPYC Venice a 256 core, le GPU Instinct MI400 (serie CDNA Next) e le schede di rete “Vulcano” 800 GbE. Il sistema rispetterà gli standard OCP (Open Compute Project), abilitando interconnessioni ad altissima velocità: a livello di rack supporta Ultra Ethernet (800 Gb/s) e l’acceleratore UALink (Ultra Accelerator Link).

AMD descrive Helios come una soluzione “unificata” per l’AI di prossima generazione: all’architettura hardware si abbina lo stack software ROCm, e il sistema punta a fornire «leadership compute density, bandwidth di memoria e connettività di scala» per training di modelli di frontiera e inferenza massiva. Gli ingegneri AMD affermano che, rispetto ai sistemi rack di NVIDIA basati su Blackwell Ultra o Rubin, Helios offrirà densità di prestazioni superiori (superando le piattaforme NVL72/NVL144 corrispondenti). Al contempo, si ammette che battere il top di gamma NVIDIA (il futuro NVL576 con Rubin Ultra previsto per il 2027) resterà una sfida, spingendo AMD a continuare l’innovazione nel ciclo post-2027.

EPYC Verano e Instinct MI500

Uno sguardo al 2027

AMD ha confermato che nel 2027 arriverà il processore server EPYC Verano (ancora con architettura Zen 6) abbinato alle future GPU Instinct MI500X. Lisa Su ha sottolineato che Verano e MI500X formeranno la seconda generazione di sistemi rack AI di AMD (quella che verrà dopo Helios, insomma). Non sono stati forniti dettagli architetturali, ma si sa che la produzione di Verano e MI500X sarà allineata al nodo TSMC A16 (con backside power delivery) a fine 2026. Ci si aspetta dunque un ulteriore aumento di densità di calcolo e potenza consumata per affrontare l’evoluzione dei sistemi concorrenti.

Le novità annunciate rafforzano la posizione di AMD nel mercato dell'accelerazione basata sull'IA, ma lo sfondo competitivo rimane complesso. Da un lato, AMD dichiara che le sue nuove GPU possono arrivare a superare le controparti NVIDIA in alcuni workload di inferenza, grazie agli aumenti di prestazioni e memoria. Dall’altro, NVIDIA mantiene il vantaggio nelle prestazioni assolute: ad esempio la futura GPU Rubin R200 offrirà circa 2.5 volte la potenza FP4 del MI400X di AMD. In pratica, AMD punta sul binomio tra calcolo e memoria e su un approccio “open” per contenere la leadership di NVIDIA, ma riconosce che battere completamente i chip top di gamma della concorrenza (come i sistemi NVL576 del 2027) è ancora una sfida.

Sul fronte CPU server, AMD continua ad alzare l’asticella: l’EPYC Venice con 256 core e banda enorme dichiara di estendere la «leadership in ogni dimensione» del data center, mettendo pressione ai processori Intel Xeon tradizionali. Intel, che dispone di grandi volumi produttivi e di soluzioni AI proprie, dovrà rispondere all’aumento di core e bandwidth offerto da AMD. In definitiva, le architetture presentate da AMD incrementano la sua competitività in termini di prestazioni per watt e costo per inferenza. Tuttavia, NVIDIA resta ancora leader di mercato sul fronte delle performance brute nel deep learning, mentre Intel punta sul proprio ecosistema software e sull’efficienza nelle infrastrutture tradizionali.